Şubat 2024'te, çok uluslu bir şirketin finans çalışanı, deepfake (derin sahtecilik) teknolojisini kullanarak şirketin mali işlerinden sorumlu yöneticisinin kimliğine bürünen dolandırıcılara 25 milyon dolar transfer etti. Bu dolandırıcılık olayında, şirket çalışanı, video konferans yoluyla bir toplantıya katılmıştı ve toplantıda gördüğü kişilerin diğer çalışanlar olduğuna inanıyordu. Oysa gördüğü tüm bu kişiler deepfake teknolojisi ile yaratılmıştı.

Yapay zeka teknolojisi ilerledikçe, gerçek ile sahte arasında ayrım yapmak zorlaşıyor ve bu tür sahtecilikler giderek artıyor. Geleneksel güvenlik yöntemleri bu yeni tehditleri ele almakta genellikle yetersiz kalıyor. Bu da organizasyonları, daha etkili çözümler aramanın yanı sıra daha bilinçli bir güvenlik yaklaşımı benimsemeye itiyor. Bu blog yazısında, deepfake’in ne olduğunu, neden giderek büyüyen bir tehdit oluşturduğunu ve SESTEK’in bu tehdide karşı etkili çözümler sunabilmek için teknoloji ve Ar-Ge’den nasıl yararlandığını ele alacağız.

Deepfake Nedir?

Derin kurgu, derin sahte, derin sahtecilik gibi isimlerle anılan deepfake teknolojisi, yapay zeka kullanarak gerçek içeriklerden öğrendiği kalıplarla orijinalinden ayırt edilmesi güç, son derece gerçekçi sahte ses, video veya görüntüler oluşturur.

Deepfake teknolojisi, yanlış bilgi yaymak, birilerinin yerine geçmek veya ses ve yüz taklitleriyle biyometrik güvenlik sistemlerini kandırmak için kullanılabilir. Örneğin, saldırganlar müşterileri veya yöneticileri taklit etmek için sahte sesler oluşturabilir, bu da yetkisiz erişime veya dolandırıcılığa yol açabilir. Biyometrik kimlik doğrulamada, derin sahtecilikle oluşturulan ses veya videolar, bir kişinin sesini veya yüzünü taklit ederek güvenlik sistemlerini aşmak için kullanılabilir. Ayrıca, yapay zeka tarafından üretilen sahte görüntü veya videolar yanlış bilgi yayabilir; bu da kurum itibarını zedeleyerek maddi kayıplara neden olabilir.

Artan Deepfake Tehdidi

Deepfake saldırılarının giderek daha gelişmiş, erişilebilir ve yaygın hale gelmesi, büyük bir güvenlik riski oluşturmalarına neden oluyor. Bu sorunun başlıca nedenlerinden biri deepfake teknolojisinin sürekli olarak gelişim göstermesi. Üretken yapay zeka (Generative AI) destekli bu teknoloji, kendi kendine öğrenme özelliği ile yeteneklerini sürekli iyileştiriyor; bu da sahte içerikleri gerçek içeriklerden ayırt etmeyi daha zor hale getiriyor. Tehdit algılama yöntemleri geliştikçe, bu yöntemleri yanıltmak için kullanılan teknikler de gelişiyor.

Bir diğer sorun ise, deepfake içeriklerin artık her zamankinden daha kolay oluşturulabilmesi. Birkaç yıl önce, ikna edici bir sahte ses üretmek için en az 30 dakikalık ses kaydı gerekirken; bugün yapay zeka modelleri, bir kişinin sesini sadece üç saniyelik bir ses kaydıyla taklit edebiliyor. Bu hızlı gelişim, saldırganlar için engelleri azaltarak, derin sahtecilik dolandırıcılıklarını daha erişilebilir bir tehdit unsuru haline getiriyor.

Bugün deepfake dolandırıcılığı, bireysel saldırıların ötesine geçerek ölçeklenebilir hale gelmiş durumda. Üretken yapay zeka sayesinde, deepfake teknolojisini kullanan dolandırıcılar minimal kaynakla aynı anda birden fazla hedefe saldırabiliyor. Bu otomasyon, deepfake dolandırıcılıklarını daha etkili hale getirerek potansiyel zararı artırıyor.

Sosyal medya ise sorunu daha da büyütüyor. Bir derin sahtecilik internette yayıldığında kontrol edilmesi veya çürütülmesi daha zor hale geliyor. İçerik sahte bile olsa, ne kadar çok kişi tarafından görülürse, o içeriğe o kadar fazla insan inanıyor. Bu durum özellikle, yöneticileri pek tanınmayan şirketleri, gerçek ve sahte içerikler arasındaki farkı ayırt etmeyi zorlaştırarak savunmasız hale getiriyor.

Deepfake Tehditleri Daha Akıllı ve Güçlü Savunmalar Gerektiriyor

Derin sahtecilikler, geleneksel dolandırıcılık faaliyetlerinden farklılık gösteriyor. Sesleri neredeyse mükemmel bir doğrulukla taklit edebilmeleri, standart güvenlik önlemleriyle tespit edilmelerini zorlaştırıyor. Kurallara ve davranışsal analizlere dayanan çoğu dolandırıcılık tespit sistemi, yapay zeka ile üretilen sahteciliklere karşı etkisiz kalıyor.

Derin sahteciliklerin hızla yayılması, kontrol altına alınmalarını zorlaştırıyor. Yanıltıcı bilgiler viral hale geldikçe, kontrol edilmeleri daha da zorlaşıyor ve bu da daha güçlü kimlik doğrulama ve sahtecilik tespit çözümlerine duyulan ihtiyacı artırıyor. Gartner, kurumların, derin sahtecilikler dahil yeni tehditleri tespit etme ve ele alma konusunda gelişmiş yeteneklere sahip tedarikçilerle çalışmasını tavsiye ediyor.

Forrester ise, derin sahtecilik önlemlerinin tek seferlik bir çözüm olarak görülmemesi gerektiğini vurgulayarak; kurumların deepfake’i sürekli bir risk olarak kabul etmeleri ve hazırlıklı kalabilmek için kaynak ayırmaları gerektiğini belirtiyor. Bu da dolandırıcılık ve hesap hırsızlığı olasılıklarına karşı yapay zeka destekli doğrulama ile ek güvenlik katmanlarının birleştirilmesini gerektiriyor.

Derin sahteciliğe karşı farkındalık da büyük önem taşıyor. Gerçek örneklerle çalışanları eğitmek, tehlikelere karşı kullanabilecekleri net stratejiler geliştirmek, kurumların deepfake tehditlerini daha etkili bir şekilde tespit etmelerini ve durdurmalarını sağlıyor.

Son olarak, bu tür tehditlere karşı hazırlıklı olmak sürekli bir yatırım gerekliliğini de beraberinde getiriyor. Kurumların güvenlik teknolojilerine yatırım yaparken, derin sahtecilik teknolojisinin gelişimine ayak uyduran ve güvenlik önlemlerini Ar-Ge çalışmalarıyla sürekli geliştiren teknoloji sağlayıcıları tercih etmesi, deepfake tehditlerine karşı ellerini güçlendiriyor.

SESTEK Farkı: Ar-Ge Desteği ile Artan Güvenlik

Yapay zeka, ses dönüştürme ve ses sentezi (TTS) teknolojilerindeki gelişmeler, son derece gerçekçi sentetik sesler üretmeyi her zamankinden daha kolay hale getirdi. Saldırganlar bu yöntemleri kullanarak bir kullanıcının sesini kaydedip yeniden oynatarak kimlik doğrulama sistemlerini aşabiliyor. Bu durum, özellikle ses tabanlı kimlik doğrulamaya güvenen bankacılık ve finans sektörleri için ciddi bir güvenlik riski oluşturuyor. Gerçek ve sentetik sesleri ayırt edebilen güvenilir çözümler geliştirmek, bu tehditleri önlemek açısından büyük önem taşıyor.

SESTEK olarak, ses teknolojileri konusundaki uzmanlığımız sayesinde bu zorluklarla mücadele etmek için güçlü ses biyometrisi çözümleri geliştiriyoruz. Ar-Ge ekibimiz, en yeni teknolojileri sürekli olarak test ediyor ve çözümlerimizi iyileştirerek yeni tehditlere karşı bir adım önde olmamızı sağlıyor.

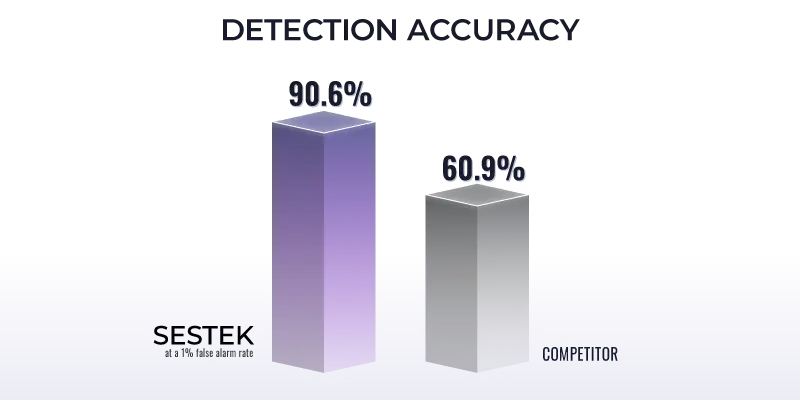

Ar-Ge’ye verdiğimiz önem, SESTEK’i deepfake tespitinde lider konuma getirdi. Ar-Ge ekibimizin kısa süre önce gerçekleştirdiği testte, modelimizin doğruluğu güvenlik alanında uzman rakip bir modelle karşılaştırıldı. Yaklaşık 2.000 örnekten oluşan bu çalışmada, "In the Wild" veri kümeleri, Azure TTS ve kendi geliştirdiğimiz SESTEK Voice Conversion gibi kaynaklar yer aldı. %1’lik yanlış alarm oranında, modelimiz %90,6 tespit doğruluğuna ulaşarak, rakibimizin %69,2 doğruluk oranını geride bıraktı.

Teknolojimiz, sektör genelinde birçok model ve sistemden daha başarılı sonuçlar sunarak akademik araştırmalarda raporlanan ölçütleri dahi aşabiliyor. Ancak bununla yetinmiyoruz. Deepfake teknolojisi geliştikçe, dolandırıcılık yöntemleri de değişiyor. Bu nedenle, çözümlerimizi sürekli olarak test ediyor, geliştiriyor ve deepfake güvenliği konusunda hep en güçlü konumda kalmamızı sağlayacak Ar-Ge faaliyetlerine ağırlık veriyoruz.

Deepfake’e Karşı Etkili Çözümlerle Güvenliğinizi Artırın

Gelişmiş biyometrik çözümlerimizin şirketinizi yeni güvenlik tehditlerine karşı nasıl koruyabileceğini görmek için bizimle iletişime geçin ve bir demo talep edin.

Yazarlar: Yusuf Sali, R&D Engineer & Debi Çakar, Product Owner at SESTEK